В современном мире высоких технологий, где скорость развертывания и отказоустойчивость приложений стали не просто желательными, а критически важными условиями успеха, мы постоянно ищем инструменты, способные помочь нам справляться с растущей сложностью. Одним из таких краеугольных камней инфраструктуры, который кардинально изменил наш подход к разработке и эксплуатации, является платформа управления циклом контейнеров Kubernetes. Это не просто инструмент; это целая философия, позволяющая нам превратить потенциальный хаос из сотен или даже тысяч контейнеров в прекрасно оркестрованный, самовосстанавливающийся механизм. Сегодня мы хотим поделиться нашим глубоким опытом и знаниями, проведя вас через все аспекты этой удивительной технологии, от её фундаментальных принципов до продвинутых стратегий использования, чтобы вы могли увидеть, как она может преобразить ваш цифровой ландшафт.

Наш путь в мире DevOps начался задолго до того, как Kubernetes стал повсеместным стандартом. Мы помним времена, когда управление приложениями в продакшене было настоящим испытанием: ручные деплои, сложные скрипты для масштабирования, часы, потраченные на отладку проблем совместимости и восстановление после сбоев. Контейнеризация, в частности Docker, принесла революцию, но и она создала новые вызовы. Как управлять сотнями контейнеров? Как обеспечить их взаимодействие? Как гарантировать, что приложение всегда доступно и работает с нужной производительностью? Именно эти вопросы привели нас к Kubernetes, и с тех пор мы не перестаем восхищаться его мощью и элегантностью. Приготовьтесь к погружению в мир, где инфраструктура становится невидимой, а приложения — гибкими и неуязвимыми.

Содержание

Toggle- Что Такое Kubernetes и Почему Мы Его Выбрали?

- Архитектура Kubernetes: Как Это Все Работает

- Фундаментальные Понятия, Которые Мы Используем Ежедневно

- Управление Ресурсами и Сетевое Взаимодействие

- Управление Хранилищем (Storage) в Kubernetes

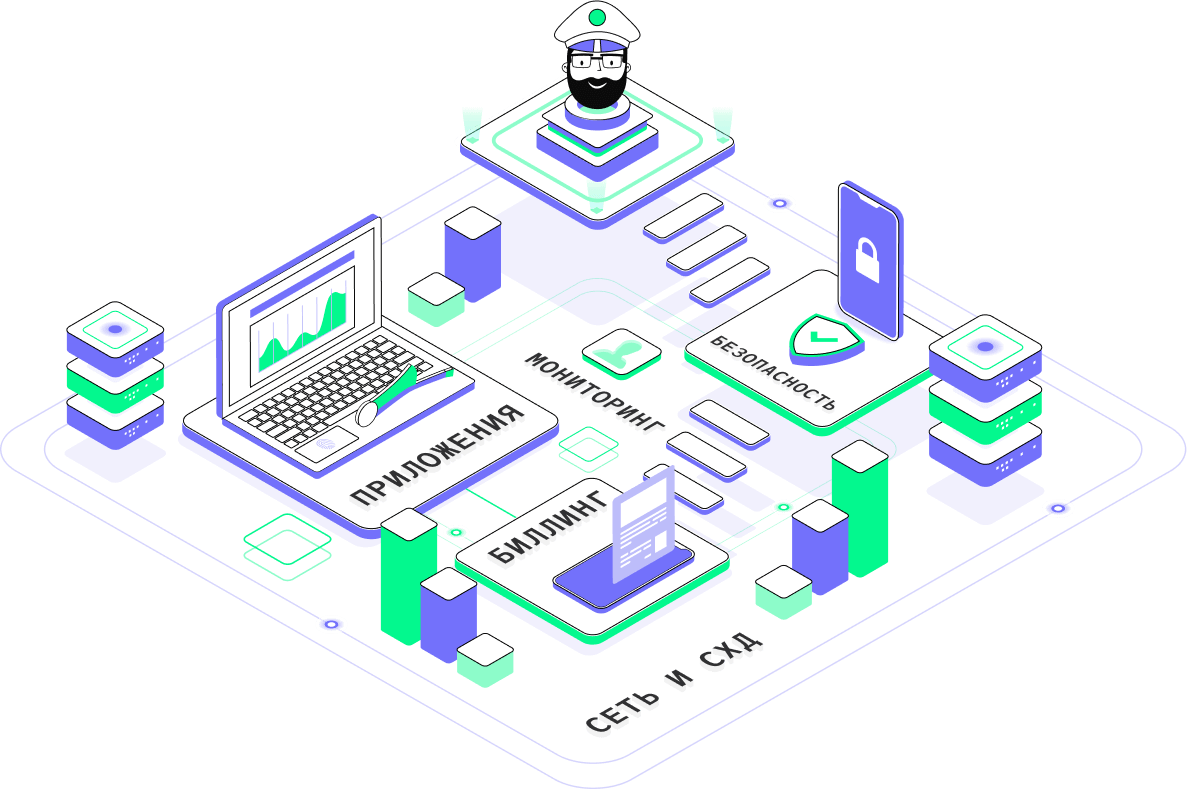

- Мониторинг, Логирование и Наблюдаемость (Observability)

- Безопасность Кластера Kubernetes: Наш Подход

- Развертывание и Жизненный Цикл Приложений

- Будущее Kubernetes и Наши Перспективы

- Наш Путь к Цифровой Гармонии с Kubernetes

Что Такое Kubernetes и Почему Мы Его Выбрали?

Прежде чем углубляться в детали, давайте разберемся, что же такое Kubernetes. Это открытая система для автоматизации развертывания, масштабирования и управления контейнеризированными приложениями. По сути, Kubernetes предоставляет нам фреймворк для запуска распределенных систем с высокой доступностью и надежностью. Задумывался он в Google, где инженеры накопили колоссальный опыт в управлении крупномасштабными системами, а затем был передан в Cloud Native Computing Foundation (CNCF), став де-факто стандартом в индустрии.

Почему мы выбрали именно Kubernetes? Причин несколько, и все они исходят из нашего стремления к эффективности и надежности. До Kubernetes мы часто сталкивались с так называемой «адской зависимостью» – когда приложение работало на одной машине, но отказывалось запускаться на другой из-за различий в окружении. Контейнеры решили эту проблему, упаковывая приложение со всеми его зависимостями. Но затем возникла проблема оркестрации: как управлять множеством таких «коробочек»? Kubernetes стал нашим ответом. Он позволяет нам декларативно описывать желаемое состояние нашей системы, а затем берет на себя всю грязную работу по его поддержанию, будь то перезапуск упавших контейнеров, масштабирование под нагрузкой или обновление без простоя.

Мы поняли, что Kubernetes не просто решает существующие проблемы, но и открывает новые возможности. Он стимулирует нас к созданию более модульных, устойчивых и масштабируемых приложений. И это не просто техническое решение; это изменение парадигмы, которое позволяет нашим командам разработчиков и операторов работать более согласованно, фокусируясь на создании ценности, а не на борьбе с инфраструктурой. Именно поэтому мы считаем, что инвестиции в изучение и внедрение Kubernetes окупаются сторицей.

Ключевые Принципы, Которые Мы Ценим в Kubernetes

За годы работы с Kubernetes мы выделили несколько фундаментальных принципов, которые, на наш взгляд, делают его таким мощным и востребованным инструментом:

- Декларативное API: Вместо того чтобы описывать как что-то сделать, мы описываем что мы хотим получить. Например, мы говорим Kubernetes: «Мы хотим, чтобы у нас всегда работало 3 экземпляра этого приложения». И Kubernetes сам находит способ это реализовать и поддерживать.

- Самовосстановление: Если контейнер падает, Kubernetes автоматически его перезапускает. Если узел выходит из строя, Kubernetes переносит его контейнеры на другие доступные узлы. Это минимизирует ручное вмешательство и повышает отказоустойчивость.

- Масштабирование: Мы можем легко масштабировать наши приложения как вручную, так и автоматически, основываясь на метриках нагрузки (например, загрузке CPU или запросам в секунду).

- Балансировка Нагрузки: Kubernetes автоматически распределяет сетевой трафик между экземплярами нашего приложения, обеспечивая равномерную нагрузку и высокую доступность.

- Управление Версиями и Откаты: Обновление приложений происходит контролируемо и поэтапно, с возможностью быстрого отката к предыдущей версии в случае проблем.

Эти принципы формируют основу того, как мы строим и управляем нашей современной инфраструктурой. Они позволяют нам спать спокойно, зная, что наши системы способны справиться с непредвиденными ситуациями и расти вместе с нашими потребностями.

Архитектура Kubernetes: Как Это Все Работает

Чтобы эффективно использовать Kubernetes, крайне важно понимать его архитектуру. Мы всегда начинаем с объяснения того, что Kubernetes кластер состоит из как минимум одного управляющего узла (Control Plane, ранее Master) и нескольких рабочих узлов (Worker Nodes). Эти компоненты работают вместе, чтобы управлять жизненным циклом наших контейнеризированных приложений.

Управляющий Узел (Control Plane) – Мозг Кластера

Control Plane — это сердце и мозг кластера Kubernetes. Он отвечает за глобальное управление кластером, принятие решений и координацию действий. В его состав входят следующие ключевые компоненты, с которыми мы постоянно взаимодействуем:

- kube-apiserver: Это фронтенд Control Plane. Он предоставляет RESTful API, через который мы (и другие компоненты) взаимодействуем с кластером. Все команды (создать, обновить, удалить ресурс) проходят через API-сервер.

- etcd: Распределенное хранилище ключ-значение, которое хранит всю конфигурацию кластера, его текущее состояние и метаданные. etcd является критически важным компонентом для стабильности кластера, и мы всегда уделяем особое внимание его резервированию и производительности.

- kube-scheduler: Отвечает за распределение новых подов на доступные рабочие узлы. Он учитывает множество факторов, таких как требования к ресурсам, политики, аффинити и анти-аффинити правил.

- kube-controller-manager: На самом деле это набор контроллеров, каждый из которых следит за определенным типом ресурсов и старается привести текущее состояние кластера к желаемому. Например, есть контроллер репликации, который следит за тем, чтобы всегда было запущено заданное количество экземпляров пода.

- cloud-controller-manager (опционально): Если вы используете Kubernetes в облаке (например, AWS, GCP, Azure), этот компонент взаимодействует с API облачного провайдера для управления ресурсами, такими как балансировщики нагрузки, сетевые маршруты или постоянные тома.

Рабочие Узлы (Worker Nodes) – Мышцы Кластера

Рабочие узлы — это машины(физические или виртуальные), на которых фактически выполняются наши контейнеризированные приложения. На каждом рабочем узле запущены следующие агенты:

- kubelet: Главный агент на каждом узле. Он общается с kube-apiserver, получает инструкции, управляет подами на этом узле (запускает, останавливает, следит за их состоянием) и отправляет отчеты о состоянии обратно в Control Plane.

- kube-proxy: Сетевой прокси, который поддерживает сетевые правила на узлах. Он обеспечивает доступность сервисов Kubernetes, перехватывая трафик и перенаправляя его на правильные поды.

- Container Runtime (например, Docker, containerd, CRI-O): Программное обеспечение, которое отвечает за запуск и управление контейнерами на узле.

Эта архитектура позволяет Kubernetes быть очень гибким и масштабируемым. Control Plane может управлять десятками, сотнями и даже тысячами рабочих узлов, обеспечивая эффективное распределение нагрузки и высокую отказоустойчивость наших приложений.

Фундаментальные Понятия, Которые Мы Используем Ежедневно

Освоение Kubernetes начинается с понимания его ключевых абстракций. Мы всегда стараемся объяснять их на примерах из реальной жизни, чтобы было проще уловить суть. Вот основные понятия, без которых мы не представляем нашей работы:

Поды (Pods) – Базовые Единицы Развертывания

Поды — это наименьшие и самые фундаментальные единицы развертывания в Kubernetes. По сути, под — это абстракция над одним или несколькими контейнерами, которые должны работать вместе на одном узле. Контейнеры в поде совместно используют сетевое пространство (IP-адрес и порты) и хранилище. Мы рассматриваем под как логический «хост» для одного или группы тесно связанных контейнеров. Если наше приложение состоит из одного контейнера, то под будет содержать только его. Если же есть основной контейнер и, например, «сайдкар» контейнер для логирования или прокси, они будут жить в одном поде.

Деплойменты (Deployments) – Управление Приложениями

Напрямую управлять подами неудобно, поскольку они не обеспечивают самовосстановления и масштабирования. Для этого мы используем Деплойменты. Деплоймент — это контроллер, который управляет набором идентичных подов. Мы описываем в Деплойменте желаемое состояние (сколько реплик пода должно быть, какую версию образа использовать), а Деплоймент обеспечивает его поддержание. Он автоматически создает, обновляет и удаляет поды. Деплойменты также позволяют нам выполнять контролируемые обновления (например, «rolling update»), плавно заменяя старые поды новыми, а также откатываться к предыдущей версии в случае проблем. Для нас Деплойменты стали основным способом управления жизненным циклом большинства наших приложений.

Сервисы (Services) – Обнаружение и Доступ

Когда у нас есть несколько подов, работающих вместе, как другие поды или внешние пользователи могут к ним обращаться? Поды динамически создаются и уничтожаются, их IP-адреса меняются. Здесь на помощь приходят Сервисы. Сервис — это абстракция, которая определяет логический набор подов и политику доступа к ним. Он предоставляет стабильный IP-адрес и DNS-имя для доступа к группе подов, независимо от того, где они находятся и какой у них текущий IP. Существуют различные типы Сервисов:

- ClusterIP: Доступен только внутри кластера.

- NodePort: Открывает порт на каждом узле кластера, направляя трафик на Сервис.

- LoadBalancer: Автоматически создает облачный балансировщик нагрузки (если кластер развернут в облаке).

- ExternalName: Перенаправляет на внешний DNS-адрес.

Сервисы — это наш главный инструмент для обеспечения коммуникации между компонентами приложения и внешним миром.

Ингресс (Ingress) – Внешний Доступ к Сервисам

Хотя Сервисы типа LoadBalancer могут предоставить внешний доступ, они обычно выделяют отдельный IP для каждого сервиса, что может быть дорого и неэффективно для большого числа микросервисов. Ингресс — это API-объект, который управляет внешним доступом к Сервисам HTTP и HTTPS. Он позволяет нам централизованно управлять маршрутизацией трафика на основе хостнейма или пути URL, обеспечивая, например, один внешний IP-адрес для доступа к множеству различных микросервисов. Мы используем Ингресс для реализации шлюзов API, TLS-терминации и сложных правил маршрутизации.

КонфигМапы (ConfigMaps) и Секреты (Secrets) – Конфигурация и Безопасность

Наши приложения часто требуют конфигурационных данных (строки подключения к базе данных, параметры логирования) и чувствительных данных (пароли, API-ключи). Мы никогда не «зашиваем» их напрямую в образы контейнеров. Для этого в Kubernetes есть:

- ConfigMaps: Для хранения нечувствительных конфигурационных данных в виде ключ-значение. Мы монтируем их как файлы в поды или используем как переменные окружения.

- Secrets: Для хранения чувствительных данных. Kubernetes хранит Секреты в etcd в закодированном виде (base64), что лучше, чем открытый текст, но для продакшена мы используем дополнительные инструменты шифрования (например, External Secrets или Sealed Secrets).

Правильное использование этих ресурсов критически важно для гибкости и безопасности наших приложений.

«Мышление системно – это не просто подход к решению проблем; это образ жизни, который позволяет нам видеть взаимосвязи, предвидеть последствия и строить более устойчивые, адаптивные системы. И Kubernetes, по своей сути, является воплощением этого системного мышления.»

— Билл Гейтс (вольная интерпретация его философии в контексте системной инженерии)

Управление Ресурсами и Сетевое Взаимодействие

Эффективное управление ресурсами и грамотная настройка сети — ключевые аспекты для стабильной и производительной работы кластера Kubernetes. Мы уделяем этому особое внимание, поскольку неправильная настройка может привести к проблемам производительности, отказам и даже потере данных.

Лимиты и Запросы Ресурсов (Limits and Requests)

В Kubernetes мы можем указывать, сколько CPU и памяти требуется для каждого контейнера в поде. Это делается с помощью полей resources.requests и resources.limits:

- Requests (Запросы): Гарантированный минимум ресурсов, которые будут выделены поду. Шедулер Kubernetes использует эти значения для размещения подов на узлах. Если узел не может предоставить запрашиваемые ресурсы, под не будет на нем запущен.

- Limits (Лимиты): Максимальное количество ресурсов, которые под может использовать. Если под превышает лимит по памяти, он будет принудительно завершен (OOMKilled). Если он превышает лимит по CPU, его производительность будет ограничена.

Мы всегда тщательно настраиваем эти параметры. Слишком низкие запросы могут привести к нестабильности, слишком высокие — к неэффективному использованию ресурсов и лишним затратам. Наш подход – начинать с консервативных запросов, основываясь на базовом тестировании, и постепенно увеличивать их по мере сбора метрик производительности в продакшене.

Сетевое Взаимодействие (Networking)

Сетевая модель Kubernetes является фундаментальной для его работы и имеет ряд ключевых принципов:

- Каждый под получает свой уникальный IP-адрес.

- Поды могут общаться друг с другом без использования NAT.

- Агенты на узлах (kubelet) могут общаться с подами без NAT.

Для реализации этой модели Kubernetes использует CNI (Container Network Interface) плагины. Мы работали с различными CNI, такими как Calico, Flannel, Cilium, и каждый из них имеет свои особенности и преимущества. Например, Calico известен своими мощными сетевыми политиками, а Cilium предоставляет возможности наблюдаемости на уровне ядра и продвинутую безопасность.

Понимание того, как выбранный CNI плагин работает под капотом, позволяет нам эффективно отлаживать проблемы с сетью и настраивать сетевые политики безопасности для изоляции микросервисов.

Пример Таблицы с Ресурсами Пода

Для наглядности, давайте представим, как мы определяем ресурсы для нашего пода:

| Параметр | Значение | Описание |

|---|---|---|

| cpu request | 500m | Запрашиваемая доля CPU (50% одного ядра) |

| cpu limit | 1000m | Максимально допустимая доля CPU (1 ядро) |

| memory request | 256Mi | Запрашиваемый объем RAM (256 мегабайт) |

| memory limit | 512Mi | Максимально допустимый объем RAM (512 мегабайт) |

Такой подход помогает нам гарантировать стабильность работы приложений и оптимальное использование аппаратных ресурсов кластера.

Управление Хранилищем (Storage) в Kubernetes

Приложения редко бывают «без сохранения состояния» (stateless). Большинство из них нуждаются в постоянном хранилище для баз данных, файловых систем, кэшей и т.д. В мире контейнеров, где поды эфемерны и могут быть перезапущены на другом узле, обеспечение сохранности данных является критически важной задачей. Kubernetes предлагает мощную и гибкую систему управления хранилищем.

Persistent Volumes (PV) и Persistent Volume Claims (PVC)

Мы используем две основные абстракции для управления постоянным хранилищем:

- PersistentVolume (PV): Это ресурс кластера, который представляет собой заранее выделенное хранилище (или динамически выделенное провизионером). PV не привязан к конкретному поду и может быть разного типа: NFS, iSCSI, облачные диски (EBS, GPD, Azure Disk) и т.д. Администратор кластера создает PVs или настраивает динамическое провизионирование.

- PersistentVolumeClaim (PVC): Это запрос на хранилище от пода. Разработчик приложения запрашивает определенный объем и тип хранилища (например, «мне нужно 10Gi SSD хранилища»). Kubernetes затем ищет подходящий PV, который удовлетворяет этому запросу, и связывает его с PVC.

Такая модель разделения (поставщик хранилища создает PV, потребитель запрашивает PVC) позволяет нам абстрагироваться от деталей инфраструктуры хранилища, делая приложения более переносимыми. Мы часто используем динамическое провизионирование, когда PVC автоматически создает PV через StorageClass.

StorageClasses – Гибкость и Автоматизация

StorageClass — это еще одна важная абстракция, которая позволяет администраторам кластера определять «классы» хранилища. Например, у нас может быть StorageClass «fast-ssd» для высокопроизводительных баз данных и «standard-hdd» для архивных данных. Когда разработчик запрашивает PVC, он может указать желаемый StorageClass, и Kubernetes автоматически выделит соответствующее хранилище, если настроен соответствующий провизионер.

Использование StorageClasses упрощает управление хранилищем в больших кластерах и позволяет нам предлагать различные типы хранилищ с разными характеристиками производительности и стоимости нашим разработчикам.

Пример использования PV/PVC/StorageClass

Представьте, что мы хотим развернуть базу данных, которой нужен постоянный диск. Мы опишем это следующим образом:

- Создадим StorageClass (если он не создан по умолчанию) с именем, например, gp2-storage, который использует облачный провизионер.

- Создадим PVC, запрашивающий 20Gi дискового пространства и указывающий storageClassName: gp2-storage.

- В спецификации пода (или Deployment’а) сошлемся на этот PVC, чтобы монтировать выделенное хранилище в контейнер.

Благодаря этому, если под с базой данных упадет и перезапустится на другом узле, он автоматически подключит тот же самый PersistentVolume, и данные будут в целости и сохранности.

Мониторинг, Логирование и Наблюдаемость (Observability)

Запуск приложений в Kubernetes — это только начало. Чтобы наши системы оставались здоровыми, производительными и безопасными, нам необходимо постоянно следить за их состоянием. Мониторинг, логирование и трассировка (в совокупности Observability) — это те инструменты, которые позволяют нам видеть, что происходит «под капотом» нашего кластера.

Мониторинг с Prometheus и Grafana

Для сбора метрик мы повсеместно используем Prometheus. Он является де-факто стандартом для мониторинга кластеров Kubernetes. Prometheus собирает метрики со всех компонентов кластера (Control Plane, kubelet, поды, узлы) и наших приложений. Мы настраиваем его для автоматического обнаружения сервисов и подов, что значительно упрощает процесс добавления новых источников метрик.

Для визуализации этих метрик и создания информативных дашбордов мы используем Grafana. Она позволяет нам создавать красивые и функциональные панели, которые показывают состояние кластера, производительность приложений, использование ресурсов и многое другое. Мы настраиваем алерты в Prometheus (Alertmanager) для уведомления нашей команды о критических событиях.

Централизованное Логирование (ELK Stack / EFK Stack)

Логи — это «черные ящики» наших приложений. В Kubernetes поды эфемерны, и логи могут быть потеряны при их перезапуске. Поэтому мы внедряем централизованную систему логирования. Чаще всего мы используем комбинацию Fluentd (или Fluent Bit), Elasticsearch и Kibana (EFK Stack):

- Fluentd/Fluent Bit: Агент для сбора логов. Он запускается на каждом узле кластера и собирает логи со всех контейнеров, а затем отправляет их в центральное хранилище.

- Elasticsearch: Распределенное хранилище для индексирования и хранения логов.

- Kibana: Веб-интерфейс для поиска, анализа и визуализации логов.

Эта система позволяет нам быстро находить ошибки, анализировать поведение приложений и проводить постмортемы инцидентов.

Трассировка (Tracing) с Jaeger/Zipkin

В микросервисной архитектуре, где запрос проходит через множество сервисов, отследить путь запроса и определить узкое место становится очень сложно. Для этого мы используем распределенную трассировку. Инструменты вроде Jaeger или Zipkin позволяют нам визуализировать путь запроса по всем микросервисам, измерять время выполнения каждого шага и быстро выявлять проблемные места. Мы интегрируем их в наши приложения с помощью OpenTelemetry или других SDK.

Вместе эти три столпа наблюдаемости дают нам полную картину происходящего в нашем кластере и позволяют принимать обоснованные решения для оптимизации и устранения неполадок.

Безопасность Кластера Kubernetes: Наш Подход

Безопасность — это не опция, а необходимость. Кластер Kubernetes — это сложная система, и её безопасность требует многоуровневого подхода. Мы подходим к этому вопросу очень серьезно, внедряя лучшие практики на каждом уровне.

Основные Принципы Безопасности

Мы придерживаемся следующих ключевых принципов при обеспечении безопасности наших кластеров:

- Принцип Наименьших Привилегий (Least Privilege): Каждому компоненту, пользователю или сервису должны быть предоставлены только те разрешения, которые ему абсолютно необходимы для выполнения его функций.

- Глубокая Защита (Defense in Depth): Внедрение нескольких слоев защиты, чтобы отказ одного слоя не приводил к полному компрометации системы.

- Автоматизация и Неизменность (Automation & Immutability): Минимизация ручных изменений и использование неизменяемой инфраструктуры для уменьшения поверхности атаки и повышения воспроизводимости.

Уровни Защиты

Мы реализуем безопасность на различных уровнях:

- Безопасность Узлов:

- Обновление ОС: Регулярное обновление операционных систем на рабочих узлах для защиты от известных уязвимостей.

- Hardening: Усиление конфигурации ОС (например, отключение ненужных сервисов, файервол).

- Изоляция: Использование отдельных узлов для чувствительных рабочих нагрузок, если это необходимо.

- Безопасность Кластера Kubernetes (Control Plane):

- RBAC (Role-Based Access Control): Строгое управление доступом пользователей и Service Accounts к API Kubernetes. Мы создаем минимально необходимые роли и связываем их с пользователями/группами/Service Accounts.

- Сетевые Политики (Network Policies): Используются для контроля трафика между подами. Мы можем определить, какие поды могут взаимодействовать друг с другом и с внешним миром. Это критично для сегментации сети и предотвращения бокового перемещения злоумышленников.

- Pod Security Admission (PSA): Ранее Pod Security Policies (PSP). Позволяет нам принудительно применять стандарты безопасности для подов, например, запрещать запуск привилегированных контейнеров или использование root-пользователя.

- Шифрование etcd: Шифрование данных etcd в состоянии покоя (at rest) для защиты критической конфигурации кластера.

- Безопасность Образов Контейнеров:

- Сканирование уязвимостей: Регулярное сканирование образов контейнеров на наличие известных уязвимостей (с использованием инструментов вроде Clair, Trivy).

- Минимальные базовые образы: Использование легковесных базовых образов (например, Alpine, Distroless) для уменьшения поверхности атаки.

- Цифровая подпись образов: Гарантия того, что запускаются только доверенные образы.

- Безопасность Приложений:

- Управление секретами: Использование Kubernetes Secrets в сочетании с внешними решениями (HashiCorp Vault, облачные сервисы секретов) для безопасного хранения и доступа к чувствительным данным.

- Принцип «Zero Trust»: Не доверять ничему по умолчанию, всегда проверять и аутентифицировать каждый запрос.

Безопасность Kubernetes — это постоянный процесс. Мы регулярно проводим аудиты, обновляем политики и следим за новыми рекомендациями, чтобы наши кластеры оставались защищенными от возникающих угроз.

Развертывание и Жизненный Цикл Приложений

Когда мы говорим о платформе управления циклом контейнеров, мы имеем в виду не только запуск приложений, но и весь их жизненный цикл: от разработки до вывода из эксплуатации. Kubernetes предоставляет мощные примитивы для автоматизации этого процесса.

CI/CD с Kubernetes

Невозможно представить современную разработку без непрерывной интеграции (CI) и непрерывной доставки/развертывания (CD). Kubernetes идеально вписывается в эти пайплайны:

- CI (Непрерывная Интеграция): Разработчики коммитят код, CI-система (Jenkins, GitLab CI, GitHub Actions) автоматически собирает образ контейнера, запускает тесты и отправляет образ в Container Registry (Docker Hub, Quay.io, GCR).

- CD (Непрерывная Доставка/Развертывание): После успешного прохождения тестов, CD-система обновляет манифесты Kubernetes (например, Deployment YAML) с новой версией образа и применяет их к кластеру. Kubernetes затем берет на себя остальную работу: постепенно обновляет поды, следит за их здоровьем и откатывается в случае проблем.

Мы часто используем подходы GitOps, где желаемое состояние кластера полностью описывается в Git-репозитории. Инструменты вроде Argo CD или Flux CD следят за этим репозиторием и автоматически синхронизируют кластер с описанным состоянием. Это делает развертывание более прозрачным, аудируемым и отказоустойчивым.

Управление Конфигурацией и Шаблонизация

Работать с YAML-файлами напрямую, особенно в больших проектах, может быть утомительно. Для управления конфигурацией и шаблонизации мы используем:

- Helm: Это пакетный менеджер для Kubernetes. Helm-чарты позволяют нам определять, устанавливать и обновлять даже самые сложные приложения Kubernetes. Мы создаем свои чарты для наших микросервисов, что делает развертывание предсказуемым и повторяемым.

- Kustomize: Инструмент для безшаблонной настройки конфигурации Kubernetes. Он позволяет нам накладывать изменения (патчи) на базовые YAML-файлы, что особенно удобно для различных окружений (dev, staging, prod).

Эти инструменты значительно упрощают нам управление десятками, а то и сотнями манифестов Kubernetes, позволяя сосредоточиться на логике приложения, а не на рутинной конфигурации.

Будущее Kubernetes и Наши Перспективы

Kubernetes не стоит на месте, он постоянно развивается. Мы видим, как он проникает во все большее число областей, от традиционных веб-приложений до граничных вычислений и машинного обучения. Наш опыт показывает, что инвестиции в эту платформу будут только расти, и она останется фундаментальной частью нашей инфраструктуры на долгие годы.

Тренды, Которые Мы Отмечаем

- Edge Computing: Kubernetes становится все более популярным для управления распределенными рабочими нагрузками на периферии сети, например, для IoT устройств или локальных микросервисов. Проекты вроде K3s демонстрируют легковесные, оптимизированные для Edge версии Kubernetes.

- Serverless и Functions-as-a-Service (FaaS): Хотя Kubernetes сам по себе не является «бессерверным», он служит отличной платформой для развертывания Serverless-решений (например, Knative, OpenFaaS). Это позволяет нам сочетать гибкость бессерверных функций с контролем и мощью Kubernetes.

- Искусственный Интеллект и Машинное Обучение (AI/ML): Тренировка и развертывание моделей машинного обучения требуют огромных вычислительных ресурсов. Kubernetes, с его способностью эффективно управлять GPU и другими специализированными аппаратными ресурсами, становится идеальной платформой для ML-операций (MLOps), позволяя командам автоматизировать весь жизненный цикл моделей.

- WebAssembly (WASM): Появление WebAssembly как формата выполнения вне браузера открывает новые горизонты. Мы следим за развитием интеграции WASM с Kubernetes, что может предложить еще более легковесные и безопасные среды выполнения.

Эти тренды показывают, что Kubernetes не просто решает текущие проблемы, но и активно формирует будущее IT-инфраструктуры. Мы всегда держим руку на пульсе, чтобы адаптировать наш подход и использовать новые возможности, которые предлагает эта платформа.

Наш Путь к Цифровой Гармонии с Kubernetes

Наш путь с Kubernetes был долгим и порой тернистым, но мы ни разу не пожалели о сделанном выборе. От первых шагов в понимании его сложной архитектуры до мастерства в управлении крупномасштабными продакшен-кластерами, мы прошли через множество испытаний и приобрели бесценный опыт. Kubernetes перевернул наше представление о том, как должны работать приложения, предоставив нам инструменты для построения систем, которые не просто работают, но и процветают в условиях постоянных изменений и высоких требований.

Он позволил нам перейти от реактивного решения проблем к проактивному проектированию, от рутинных операций к стратегическому мышлению. Мы создаем инфраструктуру, которая является не просто набором машин, а живым, адаптивным организмом, способным самостоятельно восстанавливаться, масштабироваться и эволюционировать. И это, на наш взгляд, и есть настоящая цифровая гармония.

Если вы только начинаете свое путешествие в мир Kubernetes, не бойтесь его кажущейся сложности. Да, кривая обучения существует, но награда, которую он предлагает — в виде стабильности, масштабируемости, переносимости и эффективности — стоит каждого усилия. Мы призываем вас экспериментировать, учиться и присоединяться к огромному сообществу, которое ежедневно развивает эту удивительную платформу. Пусть ваш путь в мире контейнеров будет таким же захватывающим и успешным, как наш!